پروژه پیشبینی قتل و جنایت | یادگیری ماشین در خدمت پلیس؟

اخیراً خبری دربارهٔ یکی از پروژههای وزارت دادگستری انگلیس منتشر شد که موضوع خوبی برای فکر کردن به برخی از تبعات مثبت و منفی گسترش هوش مصنوعی و علم داده است. ما هم تصمیم گرفتیم آن را در قالب یکی از تجربه های ذهنی در متمم بررسی کنیم.

گاردین و گروه استیتواچ گزارش دادند که مشخص شده دولت انگلیس مدتی است مشغول پروژهای برای پیشبینی احتمال قتل و جنایات است (+/+).

نام این پروژه در ابتدا «پروژهٔ پیشبینی قتل / homicide prediction project» بود. اما بعداً تغییر کرد و عنوان «بهاشتراکگذاری داده برای بهبود برآورد ریسک / sharing data to improve risk assessment» برای آن انتخاب شد. میشود حدس زد که عنوان جدید دو مزیت مهم دارد:

- به اندازهٔ عنوان قبلی حساسیتبرانگیز نیست (واژههایی مثل قتل در آن حذف شده).

- بسیار عمومی است و به قتل و جرائم خشونتآمیز محدود نمیشود. بنابراین این فرصت را ایجاد میکند تا به تدریج حوزههای بسیار گستردهتری را پوشش دهد.

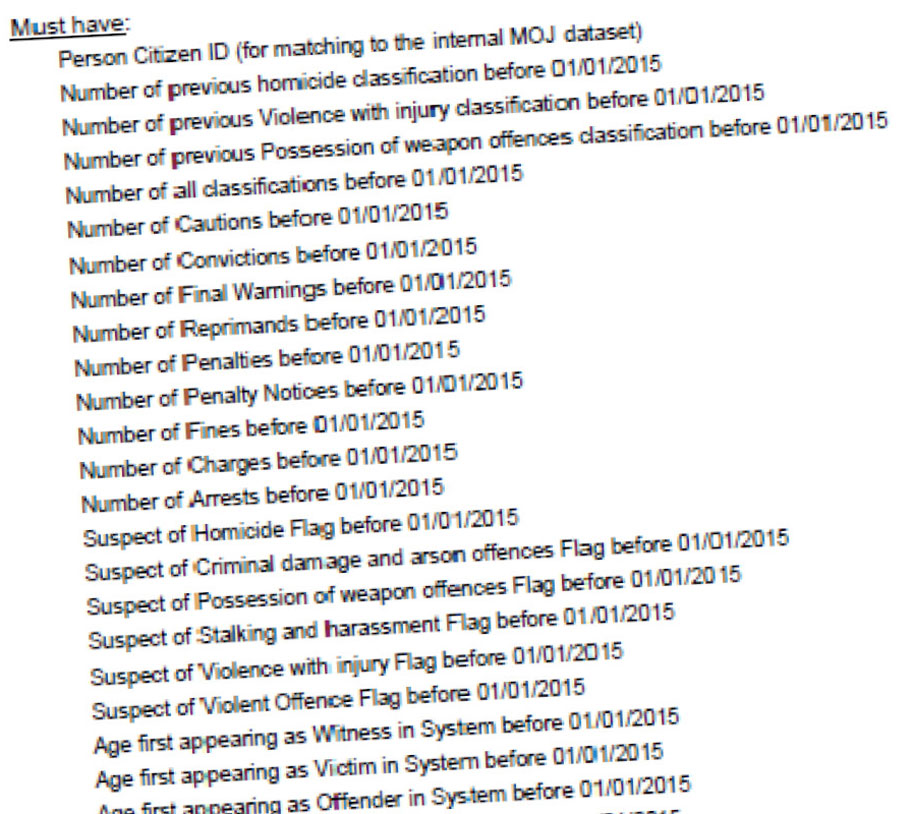

ایدهٔ پروژه نسبتاً ساده است. وزارت دادگستری مجموعهای از اطلاعات شخصی و سوابق قضایی افراد را که در آرشیوهای خود دارد، با دادههایی که در برخی مراکز پلیس ثبت شده تجمیع میکند و با استفاده از یک تیم پژوهشی متخصص علم داده، به سیستمی برای پیشبینی احتمال ارتکاب قتل و نیز پیشبینی احتمال کشته شدن میپردازد.

چنین سیستمی در حالت ایدئال، باید بتواند با دریافت ویژگیهای یک فرد (مانند سن، جنسیت، محکومیتهای قبلی، جریمههای پرداختشدهٔ قبلی، دفعات حضور در دادگاه به عنوان شاکی، شاهد یا متهم و …) حدس بزند چقدر احتمال دارد او دست به قتل بزند. وزارت دادگستری بر این باور است که چنین سیستمی میتواند به پیشگیری از وقوع جرائم کمک کند.

مخالفت گروههای مدافع حقوق شهروندی

برخی گروههای مدافع حقوق شهروندی در کشور انگلیس از اجرای چنین پروژهای بهشدت انتقاد کردهاند. آنها این پروژه را هولناک و آخرالزمانی میدانند؛ چیزی شبیه قصههایی که جورج اورول در داستان ۱۹۸۴ میگفت.

البته بلافاصله پس از انتشار عمومی خبر، وزارت دادگستری انگلیسی اعلام کرد این پروژه کاملاً تحقیقاتی است. ضمناً قرار است فقط افرادی بررسی شوند که حداقل یک بار سابقهٔ محکومیت در پروندهٔ خود دارند. اما با توجه به اطلاعات افشا شده و اینکه بین دادههای ۱۰۰ تا ۱۵۰ هزار نفر برای آموزش سیستم یادگیری ماشین بهکار رفته، نمیشود چنین ادعایی را بهسادگی پذیرفت.

نگرانی گروههای مدافع حقوق شهروندی این است که استفاده از چنین دادههایی معمولاً هزینههای اجتماعی ایجاد میکند و به افزایش تبعیض منجر میشود. چون ممکن است سیستم پلیس و نظام قضایی، کسانی را صرفاً به علت اینکه «محتمل است» جرمی مرتکب شوند، در مرتبهای پایینتر از دیگران ببیند. یا اگر چنین افرادی «متهم» به قتل شوند، قاضی حتی با شواهد کمتر (در مقایسه با دیگران) به قطعیت رسیده و آنها را قاتل تلقی کند.

علاوه بر این، ممکن است به تدریج گزارشهایی منتشر شود که نشان دهد بعضی از گروهها بیشتر از گروههای دیگر «ممکن است» قتل انجام دهند. وقتی یک سیستم با الگوریتمهای یادگیری ماشین به چنین نتیجهای برسد و این نتیجه اعلام شود (یا به بیرون درز کند) آن گروهها در معرض فشار قرار میگیرند و حتی شاید گرفتار قصاص قبل از جنایت شوند.

مثلاً مالکان یک شهرک تصمیم بگیرند برای اینکه شهرکشان حادثهخیز نباشد، به برخی از این گروهها اجازهٔ خرید یا اجارهٔ ملک در شهرکشان را ندهند.

چند سوال و سناریو برای تجربه ذهنی

شما جزو کدامیک از سه دستهٔ زیر هستید:

- عدهای با این نوع پروژهها بهشدت موافقند.

- کسانی هم هستند که معتقدند قلمرو این پروژهها باید محدود باشد. مثلاً دانشگاهیان، جامعهشناسان و برخی مراکز پژوهشی حق دارند چنین مطالعاتی انجام دهند. اما خروجی این مطالعات نباید وارد حوزهٔ سیاستگذاری شود.

- عدهای دیگر بهشدت مخالفند. آنها همچنین با گروه دوم هم مخالفند. چون معتقدند اگر خروجی قرار است در عمل هیچجا استفاده نشود، چرا باید چنین پژوهشی انجام شود؟

فرض کنید چنین سیستمی به شکل کامل طراحی و پیادهسازی شده است (در ایران یا هر کشور دیگر). شما برای هر یک از شهروندان کشور به یک عدد رسیدهاید که میشود آن را HScore (مخفف Homicide Score) نامید: عددی بین ۰٪ تا ۱۰۰٪ که احتمال ارتکاب جنایات خشن یا قتل را طی شش ماه پیش رو برآورد میکند.

- با چنین عددی چه میشود کرد؟

- آیا واقعاً چنین دادهای ارزش دارد؟

آیا میشود چنین خروجی یک سیستم یادگیری ماشین را به عنوان یکی از شواهد در دادگاه در نظر گرفت؟ بهطور مشخص، فرض کنید قتلی انجام شده و دو نفر در آن متهم هستند.

مجموع شواهد بهگونهای است که هیچ تفاوتی بین نفر الف و ب وجود ندارد. هر یک مدعی بیگناهی هستند.

الف میگوید: «من ندیدهام که ب قتل انجام دهد. اما اگر حتماً یکی از ما دو نفر قاتل است، حتماً ب است. چون من نیستم.»

ب هم با منطق مشابه الف را قاتل میداند.

خروجی الگوریتم احتمال قاتل بودن الف را ۴۰٪ و احتمال قاتل بودن ب را عددی بیشتر (مثلاً ۷۰٪) اعلام میکند. آیا میشود با اتکا به این داده و به فرض اینکه میدانیم حتماً یکی از دو نفر قاتل است، ب را محکوم کرد؟

فرض کنید بر اساس چنین سیستمی مشخص شده مهاجرانی که از شهر خاصی آمدهاند یا مذهب خاصی دارند، بهطور متوسط بیشتر از بقیهٔ مهاجران یا بقیهٔ مذاهب ممکن است قتل انجام دهند.

آیا چنین دادههایی را میشود مبنای سیاستگذاری قرار داد؟ از یک سو به نظر میرسد چنین کاری منطقی است. از سوی دیگر هم این احتمال وجود دارد که این برنامههای تبعیضآمیز، خشم و ناراحتی و تبعیضی بر علیه آن گروه ایجاد کند و واقعاً نرخ جرائم خشونتآمیز در میانشان بیشتر شود. در این حالت، سیستم هوشمند مبتنی الگوریتم عملاً حرف خودش را تأیید کرده و در آینده سختگیرانهتر از قبل به آن گروه امتیاز خواهد داد.

نهایتاً همه به نتیجه میرسند که سیستم درست کار کرده. اما ممکن است بشود تردید کرد که سیستم، جهانی را ساخته که خودش پیشبینی میکرده است.

ترتیبی که متمم برای خواندن مطالب سری علم داده به شما پیشنهاد میکند:

- علم داده چیست | کاربردهای رشته دیتا ساینس

- بازار کار علم داده | چند مثال از کاربرد علم داده به زبان ساده

- فراداده یا متادیتا چیست؟ | تفاوت داده با اطلاعات

- کلان داده یا بیگ دیتا چیست؟ (+کاربردهای Big Data)

- کتاب همه دروغ می گویند | کتابی ضعیف اما خواندنی درباره بیگ دیتا

- تاریخچه هوش مصنوعی | چگونه از زمستان هوش مصنوعی فاصله بگیریم؟

- سیستم توصیه گر چیست؟ | موتورهای پیشنهاددهنده چگونه کار میکنند؟

- معرفی کتاب سیستمهای توصیه گر | مایکل شریگ

- پرامپت نویسی برای هوش مصنوعی مولد | پیشنهاد استفاده از شاخص EE

- هوش مصنوعی و استراتژی کسب و کار | مروری بر کتاب استراتژی همجوشی

- انسانها و نکته ای در کاربرد هوش مصنوعی

- پروژه GFT | چرا گوگل در پیشبینی اپیدمی و پاندمی موفق نشد؟

- پروژه پیشبینی قتل و جنایت | یادگیری ماشین در خدمت پلیس؟

- پیتر تیل | کارآفرین، بنیانگذار پی پل و از صاحبنظران حوزه تکنولوژی

- شرکت پالانتیر (Palantir) | داده کاوی در مقیاس بزرگ برای پرسشهای خاص

- Clearview AI | آیا با اینکه هوش مصنوعی تصویر شما را تشخیص دهد موافقید؟

- انسان در برابر هوش مصنوعی | آیا کاسپاروف درباره خیانت IBM به علم درست میگوید؟

- عاملیت و اراده در هوش مصنوعی | کدام ماشین، جراح، معلم و قاضی را ترجیح میدهید؟

- هوش مصنوعی و صنعت نشر کتاب | گام جدید مایکروسافت؛ انتشارات ۸۰۸۰

- مقاله آلن تورینگ (تست تورینگ) | نقطه آغاز دوران مدرن هوش مصنوعی

- کتاب اهمیت آموزش پذیری (لزلی ولینت) | کمکی برای فهم بهتر هوش مصنوعی

- هوش یار | کتابی درباره چت جی پی تی و [کمی] هوش مصنوعی

- معرفی کتاب چت جی پی تی و آینده هوش مصنوعی | ترنس سینوسکی

چند مطلب پیشنهادی از متمم:

سوالهای پرتکرار دربارهٔ متمم

متمم مخففِ عبارت «محل توسعه مهارتهای من» است: یک فضای آموزشی آنلاین برای بحثهای مهارتی و مدیریتی.

برای آشنا شدن بیشتر با متمم به صفحهٔ درباره متمم سر بزنید و فایل صوتی معرفی متمم را دانلود کنید و گوش دهید.

فهرست دوره های آموزشی متمم را کجا ببینیم؟

هر یک از دوره های آموزشی متمم یک «نقشه راه» دارد که مسیر یادگیری آن درس را مشخص میکند. با مراجعه به صفحهٔ نقشه راه یادگیری میتوانید نقشه راههای مختلف را ببینید و با دوره های متنوع متمم آشنا شوید.

همچنین در صفحههای دوره MBA و توسعه فردی میتوانید با دوره های آموزشی متمم بیشتر آشنا شوید.

هزینه ثبت نام در متمم چقدر است؟

شما میتوانید بدون پرداخت پول در متمم به عنوان کاربر آزاد عضو شوید. اما به حدود نیمی از درسهای متمم دسترسی خواهید داشت. پیشنهاد ما این است که پس از ثبت نام به عنوان کاربر آزاد، با خرید اعتبار به عضو ویژه تبدیل شوید.

اعتبار را میتوانید به صورت ماهیانه (۲۴۰ هزار تومان)، فصلی (۶۱۰ هزار تومان)، نیمسال (یک میلیون و ۱۰۰ هزار تومان) و یکساله (یک میلیون و ۸۰۰ هزار تومان) بخرید.

توجه داشته باشید که خرید ششماهه و یکساله بهترتیب معادل ۲۰٪ و ۳۸٪ تخفیف (نسبت به خرید یکماهه) محسوب میشوند.برای اطلاعات بیشتر به صفحه ثبت نام مراجعه کنید.

آیا در متمم فایل های صوتی رایگان برای دانلود وجود دارد؟

مجموعه گسترده و متنوعی از فایلهای صوتی رایگان در رادیو متمم ارائه شده که میتوانید هر یک از آنها را دانلود کرده و گوش دهید.

همچنین دوره های صوتی آموزشی متنوعی هم در متمم وجود دارد که فهرست آنها را میتوانید در فروشگاه متمم ببینید.

با متمم همراه شوید

آیا میدانید که فقط با ثبت ایمیل و تعریف نام کاربری و رمز عبور میتوانید به جمع متممیها بپیوندید؟

نویسندهی دیدگاه : علی محمد افراسیابی

من با این پروژه ها موافقم ولی نه برای استفاده درمحاکم قضایی و نه برای سیاست گذاری های کلان وقطعی. برای تعریف یک سری اقدامات هوشمندانه میتونه کمک بکنه. باید خروجی مدل رو با داده های واقعی راستی آزمایی کرد.(آیا خروجی مدل با داده های واقعی مطابقت دارد؟) ما همین الان بدون داشتن چنین سیستمی برای امور خیلی ساده تر و کم پیامدتر سعی میکنیم چنین احتمال هایی رو در نظر بگیریم چرا برای مسایل اساسی تر استفاده از چنین داده هایی رو نادیده بگیریم؟(البته بازهم تاکید میکنم استفاده هوشمندانه وبرنامه ریزی برای اقدامات بازدارنده)

مثال1: فرض کنید شما میخواهید خودروی خود را بفروشید.اگر سیستمی وجود داشته باشه وبگه فرد خریدار به لحاظ اعتباری وضعیت مناسبی نداره و مثلا 40 درصد چک های ایشون برگشت خورده شما چه تصمیمی می گیرید؟ به نظرم محتاط خواهید شد و ممکنه به طور کل از معامله با این فرد صرف نظر کنید یا تحقیقات بیشتری کنید وبه احتمال زیاد شرایط سخت گیرانه ای برای این فرد در نظر بگیرید. این خطای تمرکز بر آخرین اطلاعات نیست و نوعی ریسک رو داره برای شما نشون میده.ممکنه شما بگید این اطلاعات مربوط به گذشته است وشاید مشکلات مالی داشته و یا شاید اصلا اصلاح شده و ... ولی در هر دو حالت(تکرار و عدم تکرار چک برگشتی)قطعیتی در کار نیست و با یک وضعیت مبهم روبرو هستیم و معمولا از ابهام و عدم قطعیت متنفریم. برای همین حالت بدبینانه رو در نظر میگیریم. ضمناً این رو هم در نظر بگیرید که خرید و فروش یک خودرو حتی اگر به کلاهبرداری ختم بشه اصلاً قابل مقایسه با قتل یک فرد نیست.

2-در ماجرای قتل امیر محمد خالقی(دانشجوی دانشگاه تهران) پلیس گزارش داد که قاتلین، محکومین سابقه داری بوده اند.(مرتکب بیش از 30 تا 40 فقره سرقت شده اند).خوب اگر سیستمی باشه که این احتمال رو بررسی کنه و اقدامات هوشمندانه و بازدارنده ای بشه تعریف کرد(به کمک جامعه شناسان و روان شناسان و...) تا از وقوع چنین جنایت هایی پیشگیری بشه چرا نباید از این داده ها استفاده کرد؟ یا بگیم حقوق شهروندی آنها مهمتره و ممکنه اصلاح شده باشند؟

3- اگرمهاجران ایرانی در یک کشور اروپایی 5 درصد جمعیت کشور اروپایی باشند و 5 درصد جرائم توسط مهاجران ایرانی انجام بشه ، منطقی نیست که دولت کشور اروپایی سیاستهایی بر ضد مهاجران ایرانی اتخاذ کنه ولی اگر مثلا 10 درصد جرائم توسط مهاجران ایرانی انجام شده کاملاً طبیعیه که محدودیتها تعریف و اعمال بشه. این اعداد رو میشه با سایر مهاجران از ملیت های دیگه هم مقایسه کرد و اگر وضعیت جامعه ایرانی مهاجر بدتر باشه به نظرم اعمال محدودیتها و اقدامات بازدارنده توجیه داره و تبعیض آمیز نیست.( هر چند در این میان تعداد زیادی از مهاجران ایرانی بدون انجام هیچ جرمی اذیت میشن .)

من راستش با این واژه تبعیض آمیز در متن درس موافق نیستم.تبعیض یعنی اختلاف گذاشتن بین دو چیز یکسان و مساوی. فرد/جامعه ای که سوابق منفی داره با فرد/جامعه ای که سوابق منفی نداره یکسان نیستند به خصوص اگر خسارتهای جبران ناپذیری ایجاد شده باشه .اینکه به لحاظ اخلاقی ما موظفیم یا توصیه میشه که افراد رو بر اساس گذشته قضاوت نکنیم و ممکنه تغییر کرده باشند بحث دیگری است.

پی نوشت: همه این تحلیل ها متکی برداده های آماریه و خود آمار هم مبتنی بر احتمالات.ما درک دقیقی از احتمال نداریم و هنوز بین فیلسوفان علم و ریاضیدانان بر سر این مفهوم اختلاف نظر جدی وجود داره. درواقع مشخص نیست احتمال یک تجربه ذهنی است یا تجربه عینی؟اگر ما به ریاضیدان ها بگیم 100 بار سکه پرتاب کردیم و دقیقا 50 بار شیرنیامد میگن تعداد رویدادها(پرتاب سکه) کم بوده اگر بی نهایت تکرار بشه اون قانون 50 درصد درسته وجواب میده. مساله اینه که ما در دنیای واقعی برای هیچ رویدادی بی نهایت تکرار نداریم. از طرفی همه دستاوردهای علمی و به تبع آن همه زندگی ما بر اساس همین احتمال بنا شده و ما با تکیه بر همین احتمال تمدن و زندگی مدرن رو سامان دادیم.(هیچ دارویی به احتمال 100 درصد اثر بخش نیست ولی مانع نمیشه که دارو مصرف نکنیم. هیچ پروازی به احتمال 100 درصد ایمن انجام نمیشه ولی ما همچنان از حمل ونقل هوایی استفاده میکنیم.)

ببخشید که طولانی شد.